Pomimo tysięcy zdjęć i filmów dokumentujących cierpienia cywilów w Gazie, obrazy wygenerowane przez sztuczną inteligencję stały się bardzo popularne. Zdjęcia te są tworzone w celu wywołania silnych emocji przez ukazywanie cierpiących niemowląt, dzieci i kobiet. Od pierwszych dni konfliktu zwolennicy Izraela i Hamasu wykorzystują AI, by pokazać bestialstwo wroga.

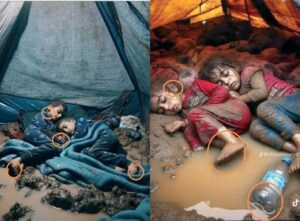

Przeanalizujmy dwa z najbardziej popularnych zdjęć, zalewających nas codziennie fake newsów. Przytulone małe dzieci śpią w błocie na ziemi przed namiotem lub w namiocie – od końca stycznia zdjęcia z tym motywem krążą na X, Facebooku, Instagramie i TikToku.

Zła liczba palców

Pierwsze zdjęcie dwóch chłopców śpiących w błocie i wodzie w namiocie, w takich samych piżamach, wyświetlono już miliony razy, a udostępniono tysiące. Przykryci niebieskim kocem trzymają się za ręce. Na pierwszy rzut oka obraz wygląda jak normalne zdjęcie, jednak wystarczy je powiększyć i można odnaleźć nieprawidłowości. Widać na nim, że chłopcy mają stopy z czterema palcami. Liczba palców jest częstym błędem, jaki popełnia sztuczna inteligencja i badając zdjęcia, warto na to zwrócić uwagę. Jeżeli przyjrzymy się ich splątanym palcom rąk, również zauważymy, że są one nienaturalnie identyczne. Poza tym, coś nie gra w okolicach potylicy chłopca po lewej stronie zdjęcia. Ta część głowy jest zbyt skośna w odniesieniu do kręgosłupa.

Oświetlenie obrazu wydaje się starannie zaaranżowane: lampa, najwyraźniej zwisająca z sufitu namiotu, oświetla scenę w miarę równomiernie i z indywidualnymi refleksami. Choć podobne efekty można osiągnąć dzięki zaawansowanym programom do edycji fotografii, samo miejsce, w którym wykonano zdjęcie, wymagałoby ustawienia doskonałego oświetlenia za pomocą zaawansowanego sprzętu w podtopionym namiocie.

Nienaturalne światło

To samo dzieje się na drugim obrazku, który pojawił się w sieci. Pomimo że tu estetyka prezentuje się delikatniej, to odbicie i gra świateł wydają się niezwykle nienaturalne, wystarczy rzucić okiem na butelkę.

Typowe błędy AI, które można dostrzec głównie na kończynach, są bardzo subtelne. Jednak po bliższym przyjrzeniu się widzimy, że dolna część lewej stopy dziewczynki jest niezwykle płaska, jakby stała na ziemi. Skóra dziewcząt, mimo iż zabrudzona, wygląda nieskazitelnie – i jest to również typowe dla obrazów generowanych przez sztuczną inteligencję. Dodatkowo jedna ze śpiących dziewczynek ma nieproporcjonalnie duże ucho.

Nie wszystko tak wygląda

Nie oznacza to jednak, że sceny tworzone przez sztuczną inteligencję nie mogą istnieć rzeczywiście. Organizacje humanitarne codziennie donoszą o skrajnych warunkach, w jakich obecnie żyją osoby przesiedlone w Strefie Gazy. W rzeczywistości po ostatnich ulewnych deszczach międzynarodowe media, CNN i Al Jazeera, doniosły, że uchodźcy próbowali wypełnić zalane namioty piaskiem, aby osuszyć kałuże.

Choć istnieje szereg wskazówek, którymi można się dziś kierować przy wykrywaniu pochodzenia zdjęcia, jak palce u nóg czy rąk, nienaturalnie wygładzona skóra czy rozmyte tło, to sztuczna inteligencja rozwija się tak szybko, że najprawdopodobniej już w kolejnych miesiącach będzie to trudniejsze. Dlatego tak ważne jest, by znać źródło pochodzenia zdjęcia.

Meta właśnie ogłosiła, że w nadchodzących miesiącach rozpocznie wykrywanie i oznaczanie obrazów generowanych przez sztuczną inteligencję.